De facto, a partir do início do século XIX, os cartões perfurados do tear Jacquard permitiam codificar informações: um furo ou a ausência de furo indicava se era necessário ou não levantar um fio antes da passagem da lançadeira, definindo assim o valor de um “pixel” do padrão a ser tecido.

DRAM, a memória que também pode esquecer tudo

O mesmo princípio funciona nos cartões perfurados usados pelo engenheiro Herman Hollerith no censo americano de 1890, e depois no cartão de 80 colunas patenteado pela IBM em 1928, que foi o suporte central da mecanografia, de certa forma a idade de bronze da computação. Mesmo antes da electrónica, numerosas máquinas electromecânicas – classificadores, perfuradores, interclassificadores, tabuladores – foram inventadas para o processamento automatizado de certos dados: contabilidade, estatísticas, censos, etc. O cartão de 80 colunas permaneceu um ícone da computação até ao início dos anos 80.

Mas para se desenvolver, o computador também precisou de outro tipo de memória, capaz de armazenar e recuperar rapidamente os resultados intermediários dos cálculos: a memória central. Uma memória de acesso direto (RAM para Random Access Memory), em oposição às memórias de acesso sequencial: só se pode ler o enésimo cartão perfurado depois de ter lido o n-1… Na década de 1950 surgiram as memórias de núcleo magnético, possibilitando armazenar bits de dados por meio de pequenos anéis de ferrita (uma cerâmica ferrimagnética) magnetizados em uma direção (pólos norte e sul) ou na outra. Robustos e duráveis (preservam seu conteúdo sem fonte de alimentação elétrica), eles reinaram sobre a jovem TI por cerca de vinte anos.

Depois veio a era dos chips, do silício: a DRAM (Dynamic RAM) apareceu em 1970. Cada bit é incorporado por um minúsculo capacitor, carregado ou não. Mas sempre acaba descarregando e por isso é preciso “atualizar” esse tipo de memória a cada poucos milissegundos. A DRAM tem muitas qualidades, mas na falta de fonte de alimentação esquece tudo…

Leia tambémComputador quântico: o problema inextricável dos erros de cálculo

Inquebrável, não volátil e miniaturizável

Para armazenamento a longo prazo, contamos com o magnetismo. Foi com o computador Univac I, em 1951, que surgiu o primeiro leitor-gravador de fita magnética, capaz de armazenar pouco mais de um megabyte em 365 metros de fita na época de metal. Você leu corretamente: 365 metros por um megabyte. Um meio de armazenamento sequencial, mas removível, a fita magnética continua sendo o método de arquivamento definitivo. Hoje, economiza terabytes (milhares de gigabytes), protegidos por cartuchos manuseados em dispositivos robóticos que acumulam petabytes (milhões de gigabytes).

Em 1956, foi novamente a IBM quem lançou o primeiro disco magnético, desta vez oferecendo acesso direto aos dados. Distribui aproximadamente 5 megabytes por 50 placas de 60 centímetros de diâmetro girando a 1.200 rotações por minuto no mesmo eixo. Hoje armazenamos terabytes em discos de 3,5 polegadas (9 cm) e até 2,5 (6 cm). Toda a literatura francófona caberia num disco atual!

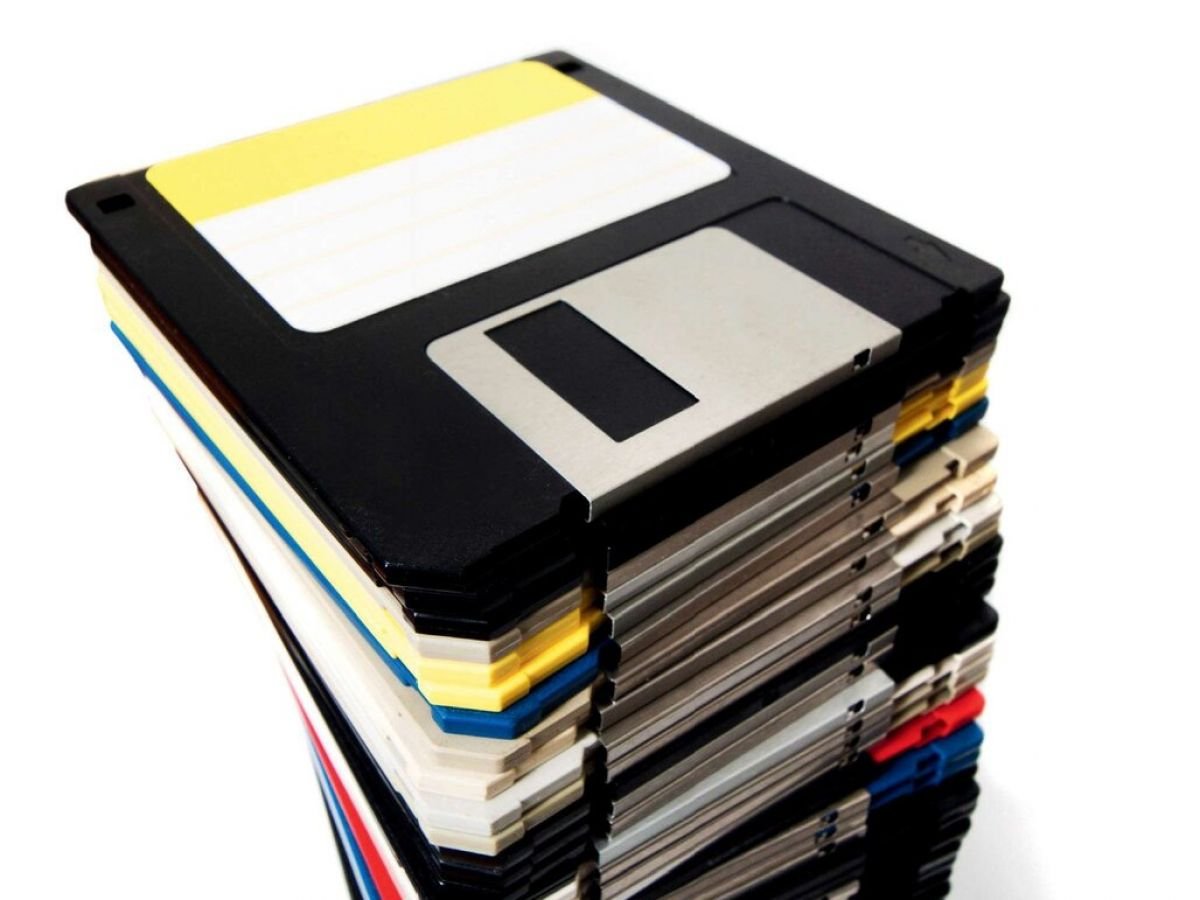

Foi novamente a IBM quem lançou a primeira unidade de armazenamento em disco removível em 1962 e, em 1971, a primeira unidade de disquete. Este apoio muito económico desempenhará um papel essencial no desenvolvimento da computação pessoal. A partir de 1982, a revolução óptica tomou conta: um feixe de laser gravou e detectou pequenos buracos em um disco de policarbonato. CD, DVD e depois Blu-ray transmitiram sucessivamente nossas músicas e filmes, antes de serem suplantados pela… internet.

Na década de 1990, surgiu em particular o SSD (Solid-State Drive), uma espécie de disco sem partes móveis, contendo chips de “memória flash”, onde cada bit é armazenado em um transistor que possui uma “porta flutuante” capaz de reter uma carga elétrica protegida por uma camada isolante de óxido de silício. Nos últimos anos, os SSDs experimentaram uma explosão de desempenho, principalmente com tempos de acesso de alguns microssegundos e consumo de energia muito reduzido, a um custo cada vez menor. Mas, calcanhar de Aquiles, a memória flash cansa com o uso: cada bit só pode ser reescrito um número limitado de vezes, por exemplo 100.000. O que torna sua gestão mais complexa.

Hoje, nos laboratórios, multiplicam-se os caminhos para a memória do futuro. Estamos considerando memórias “universais” que seriam mais rápidas que a DRAM, não voláteis, à prova de furos, miniaturizáveis e econômicas a ponto de poderem substituir nossos discos e SSDs. MRAM (Magnetic RAM) representa cada bit pela orientação relativa do campo magnético de duas camadas ferromagnéticas separadas por uma fina camada isolante. A memória de mudança de fase (PCM) depende de materiais capazes de mudar rapidamente do estado amorfo (desordenado) para o estado cristalino (ordenado) sob o efeito de pulsos térmicos. FeRAM (Ferroelectric RAM) é uma espécie de memória DRAM à qual foi adicionada uma camada ferroelétrica para obter não volatilidade. Finalmente, ReRAM (RAM resistiva) atua na criação e ruptura de filamentos condutores dentro de um material isolante.

MRAM oferece velocidade e resistência, mas sua fabricação continua cara e sua miniaturização delicada. Por ser mais denso, o PCM consome muita energia ao escrever. FeRAM, rápido e econômico, sofre de miniaturização ainda limitada. Quanto à ReRAM, prometida alta densidade e baixo consumo, ainda deve superar obstáculos técnicos, principalmente em termos de confiabilidade e repetibilidade.

Quando uma dessas tecnologias atingir a maturidade que permita a produção massiva a baixo custo, um novo tipo de computador deverá surgir, onde a RAM e a memória de armazenamento se tornarão uma só. Um playground ideal para qualquer aplicação que exija acesso imediato a dados massivos. Em particular as redes neurais, que incorporam um novo tipo de memória artificial, que não apenas armazena, mas memoriza através da aprendizagem, como o nosso cérebro.

Por Pierre Vandeginste