Muitas vezes nos é prometida uma revolução. Mas quando um modelo de código aberto estimula Claude 4.5 Opus em seu próprio terreno enquanto gerencia vídeo nativo, encontramos algo interessante. Aqui está o Kimi K2.5 que pode ser executado localmente.

Moonshot AI acaba de lembrar a todos que a China não está aqui para compensar os números.

Por trás do nome Kimi K2.5 esconde-se uma startup de Pequim que se tornou a “campeã nacional” da IA em apenas alguns meses. Liderada por Yang Zhilin, ex-funcionário do Google e da Meta, e maciçamente financiada pela Alibaba e pela Tencent, a empresa não esconde mais as suas ambições globais. A startup rapidamente se tornou um verdadeiro titã da IA avaliada em US$ 4,3 bilhões.

Kimi K2.5 não é apenas um simples chatbot. É um modelo projetado para ação. É baseado em uma arquitetura complexa do tipo Mistura de Especialistas (MoE) que totaliza cerca de um trilhão de parâmetros. Ele usa uma estrutura que permite que seja extremamente poderoso e relativamente otimizado em uso.

O modelo foi alimentado com uma quantidade estonteante de dados: cerca de 15 trilhões de tokens de texto e visão. Estamos em treinamento “multimodal nativo”, o que significa que Kimi K2.5 não apenas descreve uma imagem, ele a compreende da mesma forma que um texto.

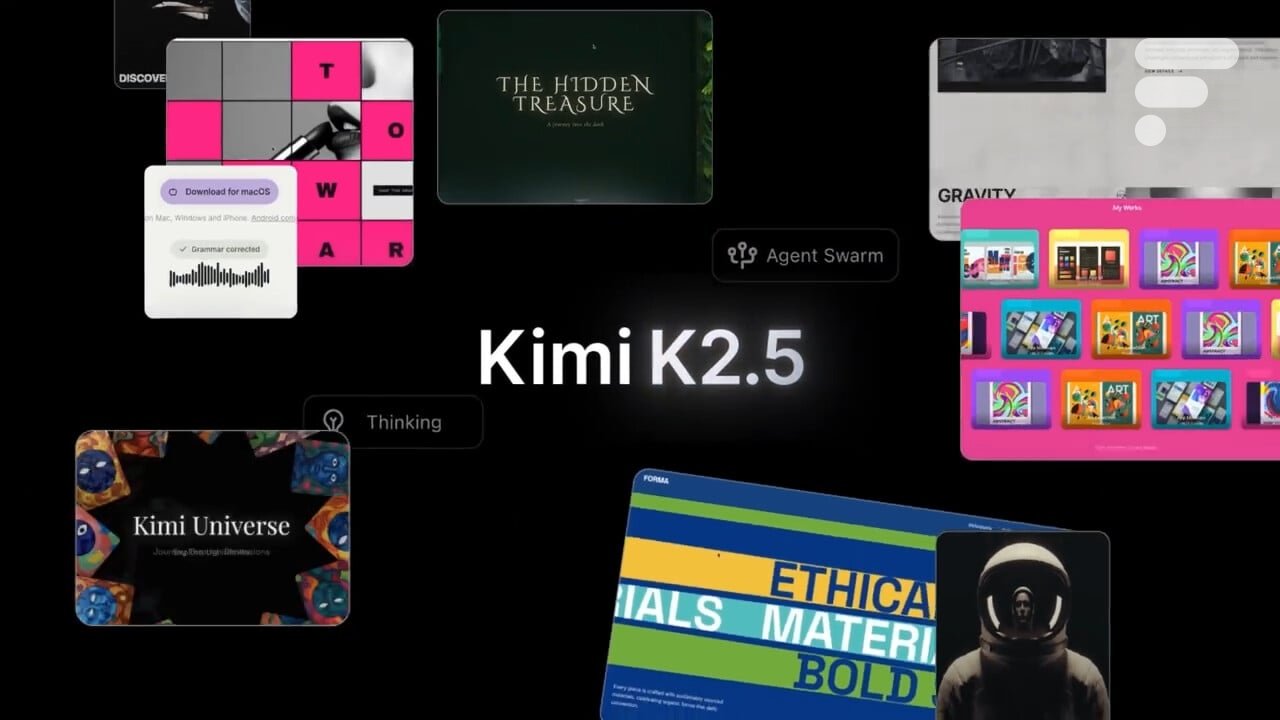

Enxame de Agente

Mas o verdadeiro avanço técnico é o que Moonshot chama de Agente Swarm. Em vez de atribuir uma missão a uma única IA, o modelo pode criar e coordenar automaticamente até 100 subagentes. Cada agente cuida de uma microtarefa, permitindo que até 1.500 chamadas de ferramentas ou API sejam lançadas em paralelo.

Concretamente, se você pedir a ele para construir um modelo financeiro complexo a partir de dez PDFs diferentes, ele não lerá os documentos um por um. Ele enviará seus agentes para extrair os dados, cruzá-los e gerar tabelas Excel simultaneamente.

| Comparativo de mercado (pesquisa de agente) | Kimi K2.5 (Enxame) | GPT-5.2 (xalto) | Claude 4.5 Opus |

| BrowseComp | 78,4 | 65,8 | 57,8 |

| Pesquisa ampla (f1) | 79,0 | – | 76,2 |

De acordo com o feedback inicial, este método é aproximadamente 4,5 vezes mais rápido que um agente tradicional. Esta é a IA “agentica” em sua forma mais concreta: ela não apenas dá a receita, ela cozinha.

Em testes de alto nível como AMOR 2025 Ou GPQA-DiamanteKimi K2.5 (no modo Thinking) está logo atrás do GPT-5.2. Mas é na parte de visão e vídeo que leva vantagem.

Este poder também se traduz em capacidades de “codificação visual” que seriam surpreendentes de acordo com o feedback inicial. Você fornece uma captura de tela de um site e ele traz de volta o código HTML/CSS pronto para uso. Estamos claramente no território de Claude 4.5 Opus, com uma agilidade técnica que poderia agradar a desenvolvedores cansados das restrições dos modelos proprietários.

O posicionamento do Moonshot AI é interessante. Ao publicar o Kimi K2.5 sob uma licença inspirada no MIT (quase open source), a startup quer criar um ecossistema global para reduzir a dependência dos modelos americanos. Esta é uma forma de confrontar diretamente a OpenAI, a Antrópica ou mesmo o Google.

É uma escolha política tanto quanto técnica. Moonshot oferece APIs compatíveis e ferramentas de ajuste fino para que todos possam adaptar este monstro às suas próprias necessidades.

E como o usamos?

Moonshot AI lança Kimi K2.5 como código aberto, mas a realidade do hardware é mais complexa. Você não conseguirá instalá-lo facilmente, mesmo que seja de código aberto e possa baixá-lo.

O modelo completo pesa 630 GB. Para executá-lo corretamente, esqueça seu laptop, Mac mini e até mesmo seu PC para jogos. Você precisará de ferramentas específicas como lhama.cpp (em versões otimizadas para a comunidade) ou Preguiça para usar versões compactadas.

Para ir mais longe

Como instalar um modelo LLM do tipo ChatGPT no PC ou Mac localmente? Aqui está o guia definitivo para todos

Aqui está o que você realmente precisa:

- A configuração “barata”: um RTX 4090 (24 GB de VRAM) e 128 GB de RAM. Você precisará usar uma versão ultracompactada (quantização de 1,8 bits). Velocidade? Cerca de 0,4 tokens por segundo. É lento e muito caro.

- A configuração recomendada: um Mac Studio M3 Ultra com 512 GB de RAM unificada. Este é o bilhete para ter um rendimento de cerca de 5 a 10 tokens por segundo. Custo da operação? Aproximadamente 14.000€.

- Modo profissional: um servidor com 4 ou 8 GPUs NVIDIA H200 (141 GB de VRAM cada). Lá, vamos além 200.000€ investimento.

Mesmo que Kimi K2.5 seja publicado como um modelo de código aberto, o ecossistema em torno de Kimi se parece muito com o que jogadores fechados como OpenAI, Google ou Anthropic oferecem: Moonshot AI fornece não apenas o LLM, mas também uma interface do tipo “ChatGPT” de acesso gratuito para testar o modelo on-line, bem como um ambiente do tipo CLI / editor on-line orientado a código, comparável ao Claude Code ou ferramentas antigas do tipo Codex (com execução, gerenciamento de arquivos, etc.), o que o torna uma plataforma completa em vez de apenas um repositório de modelo pesos.